Technisches SEO: Die Grundlage für eine erfolgreiche Website Teil 4 – Crawling und Indexierung

Letzte Bearbeitung: 22. April 2024 | meaitservices

Willkommen zum vierten Teil unserer Serie über technisches SEO, in dem wir ein kritisches, jedoch häufig unterschätztes Thema beleuchten, das fundamentale Auswirkungen auf die Sichtbarkeit und Effektivität Ihrer Website in Suchmaschinen hat: Crawling und Indexierung 🤖

Bedeutung von Crawling und Indexierung für die Sichtbarkeit in Suchmaschinen

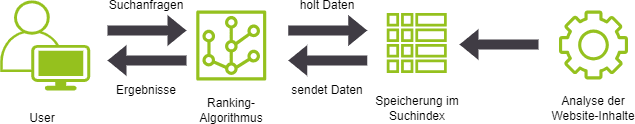

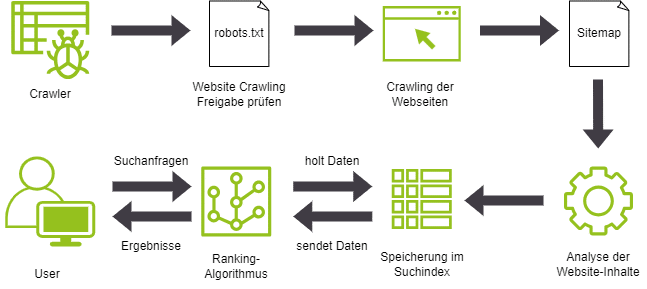

Suchmaschinen wie Google nutzen Crawler (auch bekannt als Spider oder Bots), um das Internet systematisch zu durchsuchen. Dabei sammeln sie Informationen über jede Seite zu sammeln, die sie finden. Das Crawling ist der erste Schritt im Prozess der Aufnahme einer Webseite in den Suchindex. Nachdem eine Seite gecrawlt ist, wird sie indexiert, d.h. sie wird in die Datenbank der Suchmaschine aufgenommen. Somit ist sie durch Suchanfragen auffindbar.

Die Effizienz, mit der Websites gecrawlt und indexiert werden, hängt stark von ihrer technischen Struktur und der Bereitstellung von relevanten Metadaten (Keywords und Kurzbeschreibung) ab. Das Verstehen und Optimieren des Crawling- und Indexierungsprozesses erhöht die Wahrscheinlichkeit, dass die Inhalte in den Suchergebnissen erscheinen. Das beeinflusst die Besucheranzahl der Website. Dabei hilft die Goolge Search Console, die ebenfalls Hinweise und Vorschläge zur Verbesserung anbietet.

Crawling: Wie Suchmaschinen Websites entdecken

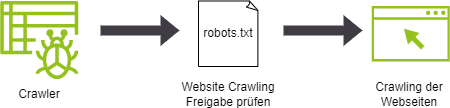

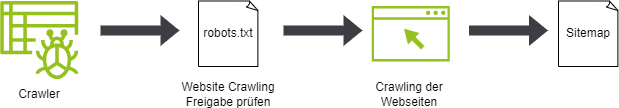

Crawling ist der Prozess, durch den Suchmaschinen wie Google das Internet systematisch durchsuchen. Dadurch werden neue und aktualisierte Inhalte entdeckt und indizieren. Dies geschieht durch so genannte Crawler oder Spider, automatisierte Bots, die von Seite zu Seite springen, indem sie Links folgen. Jedes Mal, wenn ein Crawler eine Webseite besucht, sammelt er Daten über die Seite. Diese sendet er zurück an die Suchmaschine, damit sie in deren Index aufgenommen werden können. Die Effizienz dieses Prozesses wird stark von der Struktur der Website, der Zugänglichkeit der Seiten und der Qualität der internen Verlinkung beeinflusst. Eine gut strukturierte, leicht zugängliche Website mit klaren und relevanten Links wird von Suchmaschinen-Crawlern effizienter durchsucht. Das erhöht die Wahrscheinlichkeit, dass die Inhalte schnell gefunden und indexiert werden. Daher ist es entscheidend, dass man Seiten für das Crawling optimieren, um die Sichtbarkeit und Auffindbarkeit der Website-Inhalte zu maximieren.

robots.txt

Zusätzlich spielen die Datei robots.txt und Sitemaps eine wesentliche Rolle in diesem Prozess. Die robots.txt-Datei ermöglicht es, den Suchmaschinen-Crawlern Anweisungen zu geben, welche Bereiche der Website nicht gecrawlt werden sollen. Dies hilft, die Ressourcen des Crawlers effizienter zu nutzen und sicherzustellen, dass nur relevante Seiten indexiert werden.

Sitemaps

Sitemaps hingegen bieten eine strukturierte Übersicht aller Seiten einer Website und erleichtern den Suchmaschinen die vollständige Erfassung des Inhalts der Website. Insbesondere bei umfangreichen oder tief strukturierten Websites ist das vom Vorteil. Das Bereitstellen einer klaren und umfassenden Sitemap kann die Crawling-Effizienz erheblich verbessern und dazu beitragen, dass alle gewünschten Seiten im Index der Suchmaschine landen.

Indexierung: Der Weg von Websites in den Suchindex

Indexierung ist der Schritt nach dem Crawling, bei dem eine Suchmaschine die gesammelten Daten einer Webseite verarbeitet und in ihren Suchindex aufnimmt. In diesem Prozess analysiert die Suchmaschine den Inhalt, die Struktur und die Relevanz der Seite, um zu entscheiden, wie und wo sie in den Suchergebnissen angezeigt wird. Dieser Index ist im Wesentlichen eine riesige Datenbank, die alle Informationen enthält, die es den Suchmaschinen ermöglichen, blitzschnell die relevantesten Ergebnisse zu liefern, wenn ein Nutzer eine Suchanfrage stellt. Für Webseitenbetreiber ist es daher wichtig, sicherzustellen, dass ihre Inhalte nicht nur für Crawler zugänglich sind, sondern auch so gestaltet sind, dass sie für die Indexierung optimiert sind. Das beinhaltet die Verwendung relevanter Keywords, die Bereitstellung klarer Meta-Informationen und die Sicherstellung, dass der Inhalt auf der Seite für die Suchmaschinen-Bots deutlich und eindeutig interpretierbar ist. Dadurch wird die Wahrscheinlichkeit erhöht, dass die Seite effektiv indexiert wird und eine gute Position in den Suchergebnissen erzielt.

Google-Indexierung verbessern: Ein Leitfaden

Durch die Umsetzung folgender Schritte können Sie die Sichtbarkeit Ihrer Website in den Suchergebnissen erhöhen und sicherstellen, dass Ihre Inhalte von Google effektiv und schnell indexiert werden.

- Sitemap einreichen: Erstellen Sie eine XML-Sitemap, die alle wichtigen Seiten Ihrer Website enthält, und reichen Sie diese über die Google Search Console ein. Dies hilft Google, Ihre Website effizienter zu crawlen und zu indexieren.

- Robots.txt optimieren: Überprüfen und optimieren Sie Ihre robots.txt-Datei, um sicherzustellen, dass Suchmaschinen auf die wichtigen Seiten Ihrer Website zugreifen können.

- Interne Verlinkung verbessern: Stärken Sie die interne Linkstruktur Ihrer Website. Sorgen Sie für klare und logische Verbindungen zwischen den Seiten, um Crawlern das Navigieren und Erfassen aller Inhalte zu erleichtern.

- Ladezeiten reduzieren: Optimieren Sie die Ladezeiten Ihrer Website. Google bevorzugt schnell ladende Seiten und indexiert diese schneller.

- Responsives Webdesign verwenden: Stellen Sie sicher, dass Ihre Website mobilfreundlich ist, da Google einen mobilen Index bevorzugt. Eine mobil-optimierte Seite verbessert nicht nur die Nutzererfahrung, sondern fördert auch eine bessere Indexierung.

- Inhalte aktualisieren und erweitern: Regelmäßiges Aktualisieren Ihrer Website mit qualitativ hochwertigem und relevantem Inhalt kann die Crawling-Frequenz erhöhen. Frischer Content zieht regelmäßig Suchmaschinen-Crawler an.

- HTTPS verwenden: Sorgen Sie für eine sichere Verbindung durch HTTPS. Google hat angekündigt, dass das Vorhandensein eines SSL-Zertifikats ein Rankingfaktor ist, was auch die Indexierung beeinflussen kann.

- Klare Meta-Tags verwenden: Definieren Sie präzise Meta-Tags für jede Seite (insbesondere den Title-Tag und die Meta-Description), die den Inhalt der Seite klar reflektieren und Schlüsselwörter enthalten, nach denen Ihre Zielgruppe sucht.

- Verwendung von strukturierten Daten: Implementieren Sie strukturierte Daten, um Google zusätzliche Informationen über den Inhalt Ihrer Seiten zu geben. Dies kann die Indexierung verbessern und Ihre Inhalte für spezifische Suchanfragen relevanter machen.

- Fehler beheben: Überwachen Sie regelmäßig die Google Search Console, um Crawling-Fehler oder Indexierungsprobleme zu identifizieren und zu beheben. Korrigieren Sie Fehler wie 404-Seiten, Zugriffsfehler oder doppelte Inhalte.

Fazit

Das erfolgreiche Crawling und die effektive Indexierung sind entscheidende Säulen des technischen SEO, die nicht nur die Sichtbarkeit und Auffindbarkeit von Websites verbessern, sondern auch wesentlich zur Gesamtperformance der Online-Präsenz beitragen. Indem Sie die in dieser Serie vorgestellten Techniken und Strategien anwenden, können Sie sicherstellen, dass Ihre Inhalte von Suchmaschinen wie Google effizient erfasst und korrekt im Suchindex abgebildet werden. Die Optimierung Ihrer Website führt nicht nur zu einer besseren Benutzererfahrung, sondern erhöht auch die Chancen auf höhere Rankings und mehr organischen Traffic. Vergegenwärtigen Sie sich, dass technisches SEO eine fortlaufende Aufgabe ist – regelmäßige Überprüfungen und Anpassungen sind unerlässlich, um mit den sich ständig ändernden Algorithmen der Suchmaschinen Schritt zu halten und Ihre Webpräsenz zukunftssicher zu machen.

Hier finden Sie den vorigen Beitrag zu “Technisches SEO: Die Grundlage für eine erfolgreiche Website Teil 3 – Sicherheit im Fokus mit HTTPS und SSL”.